Rozwój sztucznej inteligencji (AI) stanowi fascynującą i złożoną historię przenikania się idei, przełomowych odkryć oraz okresów stagnacji i sceptycyzmu. Od pierwszych prób formalizacji procesów myślowych w kategoriach logiki matematycznej, przez symboliczne systemy wnioskujące, aż po współczesne modele oparte na głębokim uczeniu i sieciach neuronowych, ewolucja AI odzwierciedla zmieniające się paradygmaty w nauce, technologii oraz w samej koncepcji poznania

Od samego początku sztuczna inteligencja rozwijała się na styku wielu dyscyplin: matematyki, logiki, neuronauki, filozofii umysłu, lingwistyki i informatyki. Każda z tych dziedzin wniosła unikalne narzędzia pojęciowe i metodologiczne, umożliwiające konstruowanie modeli obliczeniowych, które miały na celu symulację, a z czasem i rozszerzenie, możliwości ludzkiego poznania.

Z biegiem dekad zmieniały się nie tylko techniki i algorytmy, lecz także same wyobrażenia o tym, czym jest inteligencja i w jaki sposób można ją ująć w ramach formalnych czy obliczeniowych. Historia AI to nieustanny dialog między teorią a praktyką – między spekulacją a tym, co możliwe technologicznie. To również historia idei, które potrafiły przetrwać dekady zapomnienia, by powrócić w nowym kontekście i nadać kierunek przyszłości.

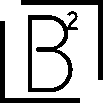

Zrozumienie tej ewolucji pozwala nie tylko lepiej ocenić aktualny stan sztucznej inteligencji, ale też dostrzec, jak głęboko zakorzenione są dzisiejsze wyzwania w długim i często zaskakującym procesie jej rozwoju. Dla większej przejrzystości historię AI podzielono tutaj na dwie części: XX wiek – jako czas narodzin idei i pierwszych eksperymentów – oraz XXI wiek, w którym sztuczna inteligencja zaczęła realnie wpływać na codzienne życie.

Fundamenty AI

-

1943: Warren McCulloch i Walter Pitts – opublikacja pracy o sieciach neuronowych

W 1943 roku, na Uniwersytecie Chicagowskim, Warren McCulloch, neurofizjolog i filozof, oraz Walter Pitts, młody matematyk, zaprezentowali przełomowy model logicznego działania neuronów w publikacji zatytułowanej A Logical Calculus of the Ideas Immanent in Nervous Activity, opublikowanej w czasopiśmie Bulletin of Mathematical Biophysics. Ich współpraca zaowocowała pierwszym matematycznym modelem sztucznego neuronu, opartym na logice zdań.

McCulloch i Pitts wykazali, że podstawowe procesy zachodzące w mózgu można odwzorować przy użyciu operatorów logicznych takich jak AND, OR i NOT. Stworzyli tym samym formalne podstawy dla tworzenia sztucznych sieci neuronowych, zdolnych do wykonywania obliczeń, wnioskowania i potencjalnego uczenia się. Choć ich koncepcja nie zdobyła uznania w środowisku neurologicznym, miała istotny wpływ na rozwój informatyki teoretycznej i przyszłych badań nad AI, stając się fundamentem dla tzw. konekcjonizmu.

- 1950: Alan Turing – koncepcja testu Turinga

W artykule Computing Machinery and Intelligence opublikowanym w czasopiśmie Mind, Alan Turing zaproponował test mający na celu określenie, czy maszyna może wykazywać inteligencję nierozróżnialną od ludzkiej. Znany dziś jako test Turinga, miał on formę eksperymentu myślowego, w którym człowiek prowadził konwersację zarówno z drugim człowiekiem, jak i z maszyną – jeśli nie był w stanie ich odróżnić, uznawano, że maszyna przejawia inteligencję.

Turing odszedł od tradycyjnego pytania „czy maszyny mogą myśleć?” na rzecz praktycznej oceny wyników ich działania. Jego propozycja stała się nie tylko filozoficzną prowokacją, ale również trwałym punktem odniesienia dla projektowania i ewaluacji inteligentnych systemów.

Narodziny sztucznej inteligencji

- 1956: Konferencja Dartmouth i narodziny terminologii

W 1956 roku w Dartmouth College odbyła się konferencja, która oficjalnie zapoczątkowała dziedzinę sztucznej inteligencji. Spotkanie zainicjowane przez Johna McCarthy’ego zgromadziło interdyscyplinarne grono badaczy (m.in. Minsky, Newell, Simon), których celem było zbadanie, czy każdy aspekt inteligencji można sformalizować i zaimplementować w maszynie. To właśnie wtedy po raz pierwszy użyto terminu artificial intelligence, co stanowiło moment definiujący dla całej dziedziny.

- 1956: Powstanie pierwszego programu AI – Logic Theorist

W ramach prezentacji na konferencji w Dartmouth zaprezentowano program Logic Theorist, opracowany przez Allena Newella, Herberta Simona i Cliffa Shawa. Program był zdolny do rozwiązywania twierdzeń z Principia Mathematica i uchodzi za pierwszy przykład sztucznej inteligencji realizującej rozumowanie symboliczne. Wykorzystanie formalnych reguł logiki do dowodzenia twierdzeń matematycznych stanowiło przejaw obliczeniowego modelu poznania, który zdominował wczesny etap badań nad AI.

Ekspansja oraz pierwsza Zima AI

- Początek lat 70.: Rozwój algorytmów i optymizm

W latach 60. i na początku 70. XX wieku badania nad sztuczną inteligencją rozwijały się w zawrotnym tempie. Rosnąca moc obliczeniowa oraz pojawienie się pionierskich systemów – takich jak ELIZA Josepha Weizenbauma czy General Problem Solver autorstwa Allena Newella i Herberta Simona – dawały nadzieję na szybkie przełomy. Znaczące wsparcie finansowe, szczególnie ze strony agencji DARPA, umożliwiało realizację ambitnych projektów i eksperymentów. W środowisku naukowym panował entuzjazm – Marvin Minsky nie wahał się przewidywać, że już wkrótce maszyny dorównają ludziom pod względem inteligencji. Jednak ten nadmierny optymizm szybko zderzył się z rzeczywistością: ograniczenia sprzętowe, niedojrzałość algorytmów i złożoność problemów poznawczych zaczęły hamować postęp.

- Końcówka lat 70.: Pierwsza zima AI – spadek zainteresowania i finansowania

W miarę upływu lat stawało się coraz bardziej oczywiste, że technologia nie jest jeszcze gotowa, by sprostać ambitnym celom. Komputery były zbyt wolne i zbyt ograniczone, by skutecznie analizować język naturalny czy podejmować decyzje w złożonych środowiskach. Hans Moravec trafnie zauważył, że komputery były wciąż miliony razy za słabe, by wykazać choćby cień prawdziwej inteligencji. Rozczarowanie rosło, a wraz z nim spadały inwestycje. Nastał okres stagnacji, który trwał blisko dekadę, a czas ten przeszedł do historii jako pierwsza „zima AI” (AI Winter).

Odrodzenie AI i systemy eksperckie

- Lata 80.: Renesans AI dzięki systemom eksperckim

Systemy eksperckie to programy komputerowe stworzone po to, by naśladować sposób, w jaki decyzje podejmują doświadczeni specjaliści. Wykorzystując bazę wiedzy z określonej dziedziny oraz zestaw reguł wnioskowania, potrafią analizować złożone przypadki i sugerować trafne rozwiązania – często szybciej i dokładniej niż człowiek. Ich potencjał szczególnie ujawnił się w obszarach takich jak medycyna czy przemysł, gdzie ogrom danych i konieczność precyzyjnych decyzji wykraczały poza ludzkie możliwości. Sukces tych systemów w latach 80. sprawił, że sztuczna inteligencja ponownie znalazła się w centrum zainteresowania i otrzymała nowy impuls do rozwoju..

- 1986: Powstanie algorytmu propagacji wstecznej

Kolejnym przełomem okazało się opracowanie algorytmu wstecznej propagacji błędów (backpropagation) przez Davida Rumelharta, Geoffreya Hintona i Ronalda Williamsa. To właśnie dzięki niemu sieci neuronowe mogły wreszcie uczyć się w sposób efektywny – korygując swoje wewnętrzne połączenia na podstawie popełnianych błędów. Algorytm ten umożliwiał precyzyjne dostosowywanie wag w sieci, co znacząco poprawiło jej zdolność do rozwiązywania złożonych problemów i otworzyło drogę do bardziej zaawansowanych modeli poznawczych.

Wzrost znaczenia uczenia maszynowego

- Lata 90.: Przesunięcie uwagi na uczenie maszynowe

Uczenie maszynowe (machine learning) szybko wyrosło na jeden z filarów współczesnej sztucznej inteligencji. Zamiast ręcznie programować każdy etap działania, zaczęto tworzyć algorytmy zdolne do samodzielnego uczenia się na podstawie danych. To podejście pozwoliło komputerom rozpoznawać twarze, tłumaczyć języki, przewidywać zachowania użytkowników – a wszystko to bez sztywnego zestawu reguł. Właśnie tam, gdzie tradycyjne systemy eksperckie i logika formalna okazywały się zbyt sztywne lub nieefektywne, uczenie maszynowe zaczęło pokazywać swoją prawdziwą siłę.

- 1997: Deep Blue pokonuje Garry’ego Kasparova w szachach

Zwycięstwo superkomputera Deep Blue nad mistrzem świata w szachach, Garrym Kasparovem, w 1997 roku, przeszło do historii jako symboliczny moment – pierwszy raz maszyna pokonała człowieka w grze uważanej za bastion ludzkiego intelektu. Szachy wymagają nie tylko logiki, lecz także strategicznego planowania, przewidywania ruchów przeciwnika i adaptacji – a więc umiejętności, które przez dekady uchodziły za wyłącznie ludzkie.

Ten pojedynek nie tylko wstrząsnął opinią publiczną, ale też wyraźnie pokazał, że sztuczna inteligencja może przekraczać granice dotąd uznawane za nieprzekraczalne. Sukces Deep Blue wywołał falę nowych inwestycji i badań, rozpoczynając kolejną fazę dynamicznego rozwoju AI.

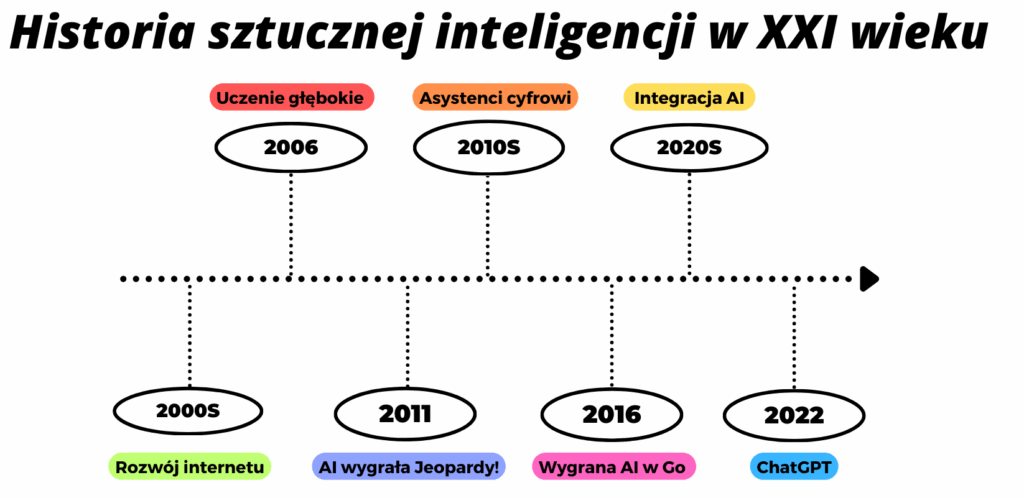

Big Data i zaawansowane algorytmy

- Początek lat 2000.: Eksplozja danych i nowy impuls dla AI

Rozwój Internetu i gwałtowny wzrost ilości danych cyfrowych stały się punktem zwrotnym dla uczenia maszynowego. Każda aktywność online – od kliknięć i transakcji po wiadomości i wyszukiwania – zaczęła generować ogromne ilości informacji, które okazały się idealnym paliwem do trenowania modeli AI. Im więcej danych, tym lepiej algorytmy mogły się uczyć, identyfikować wzorce i podejmować trafne decyzje.

Dostęp do danych z rzeczywistego świata pozwolił tworzyć bardziej precyzyjne, elastyczne i skuteczne aplikacje. Internet nie tylko zrewolucjonizował zbieranie informacji, ale też zwiększył możliwości ich przetwarzania, otwierając przed sztuczną inteligencją zupełnie nowe perspektywy.

- 2006: Głębokie uczenie- nowy poziom AI

W 2006 roku Geoffrey Hinton wraz ze współpracownikami zaprezentował podejście, które miało zrewolucjonizować sztuczną inteligencję – deep learning, czyli głębokie uczenie. Wykorzystując wielowarstwowe sieci neuronowe, udało się stworzyć modele zdolne do samodzielnego wyodrębniania cech z danych – bez potrzeby ręcznego definiowania reguł i struktur.

To podejście okazało się szczególnie skuteczne w analizie złożonych typów danych, takich jak obrazy, dźwięk czy tekst. Modele głębokiego uczenia zaczęły osiągać niespotykaną wcześniej precyzję, a ich zastosowania szybko objęły niemal każdą dziedzinę: od rozpoznawania mowy i wizji komputerowej, po tłumaczenia maszynowe i analizę języka naturalnego.

Przełom Hintona był czymś więcej niż tylko techniczną innowacją – zapoczątkował erę nowoczesnej AI, której tempo rozwoju zaczęło gwałtownie przyspieszać.

AI w życiu codziennym

- 2011: Watson firmy IBM wygrywa w teleturnieju „Jeopardy!”, udowadniając zdolność AI do rozumienia języka naturalnego

Zwycięstwo Watsona, superkomputera stworzonego przez IBM, w amerykańskim teleturnieju Jeopardy! było przełomowym momentem w rozwoju sztucznej inteligencji. Po raz pierwszy maszyna nie tylko zrozumiała pytania zadane w potocznym, pełnym dwuznaczności języku, ale potrafiła także udzielić trafnych i szybkich odpowiedzi – często lepiej niż ludzcy rywale.

Watson zmierzył się z zagadkami opartymi na grach słownych, aluzjach kulturowych i subtelnym humorze – elementach, które dotąd uchodziły za nieosiągalne dla algorytmów. Ten sukces pokazał, że AI może skutecznie operować językiem naturalnym i rozumieć kontekst – co natychmiast wzbudziło zainteresowanie zastosowaniami w poważniejszych dziedzinach, takich jak medycyna czy analiza dokumentacji naukowej.

- 2011–2016: Asystenci głosowi w codziennym życiu

W latach 2011–2016 sztuczna inteligencja zaczęła wkraczać do codzienności milionów ludzi za sprawą cyfrowych asystentów, takich jak Siri, Alexa czy Google Assistant. Dzięki rozpoznawaniu mowy i analizie języka naturalnego, systemy te umożliwiły głosowe sterowanie urządzeniami, wyszukiwanie informacji, zarządzanie kalendarzem, a nawet obsługę inteligentnych domów.

Ich działanie opiera się na ciągłym uczeniu – asystenci analizują zachowania użytkowników, by z czasem oferować coraz bardziej trafne, spersonalizowane odpowiedzi i sugestie. Co istotne, technologia AI przestała być domeną laboratoriów i specjalistów – trafiła do smartfonów, głośników i codziennych interakcji, stając się narzędziem powszechnym i intuicyjnym, niezależnie od poziomu wiedzy technicznej użytkownika.

- 2016: AlphaGo od Google pokonuje mistrza świata w Go

Zwycięstwo AlphaGo, systemu stworzonego przez Google DeepMind, nad Lee Sedolem (jednym z najlepszych graczy w historii gry Go) było kolejnym przełomem na osi czasu rozwoju sztucznej inteligencji. Gra Go, znacznie bardziej złożona niż szachy, charakteryzuje się niemal nieskończoną liczbą możliwych posunięć i wymaga głębokiego, strategicznego myślenia.

AlphaGo opanował tę sztukę dzięki połączeniu głębokiego uczenia z uczeniem przez wzmacnianie. Trenował nie tylko na partiach rozegranych przez ludzi, ale także sam ze sobą – tysiące razy, ucząc się, jak wygrywać coraz skuteczniej. Tym samym udowodnił, że AI może nie tylko przetwarzać dane, ale też rozwijać własne strategie, adaptować się do przeciwnika i działać w sytuacjach nieprzewidywalnych. Ten sukces wykraczał daleko poza świat gier – zapowiadał nowe możliwości AI w obszarach wymagających elastycznego myślenia i autonomicznego podejmowania decyzji.

Etyka AI i dalszy rozwój

- Lata 2020.: Etyczna AI, wyjaśnialność i odpowiedzialność technologii

Wraz z coraz szerszym zastosowaniem sztucznej inteligencji w medycynie, finansach, transporcie i administracji, pojawiło się jedno z najważniejszych wyzwań współczesnej technologii – jak sprawić, by AI była nie tylko skuteczna, ale również etyczna. Kwestie takie jak prywatność, brak uprzedzeń, odpowiedzialność za decyzje czy przejrzystość działania systemów zaczęły odgrywać kluczową rolę w projektowaniu i wdrażaniu inteligentnych rozwiązań.

Na pierwszy plan wysunęło się pojęcie Explainable AI (XAI) – czyli sztucznej inteligencji, której decyzje można zrozumieć i wyjaśnić. Ma to szczególne znaczenie w dziedzinach o wysokiej odpowiedzialności, takich jak diagnostyka medyczna czy analiza ryzyka w finansach, gdzie brak zaufania do algorytmu może mieć realne konsekwencje.

Równocześnie rozwój pojazdów autonomicznych pokazał, że AI zaczyna podejmować decyzje wpływające bezpośrednio na ludzkie życie i bezpieczeństwo. W efekcie coraz większy nacisk kładzie się na tworzenie systemów, które nie tylko działają skutecznie, ale również są transparentne, sprawiedliwe i odpowiedzialne społecznie.

- 2022: Premiera ChatGPT

Premiera ChatGPT od OpenAI była momentem przełomowym w rozwoju konwersacyjnej sztucznej inteligencji. Model oparty na architekturze Generative Pre-trained Transformer (GPT) osiągnął niespotykany wcześniej poziom naturalności w prowadzeniu dialogu – generując wypowiedzi, które są nie tylko poprawne gramatycznie, ale również logiczne, kontekstowo trafne i zadziwiająco płynne.

ChatGPT szybko znalazł zastosowanie w edukacji, obsłudze klienta, programowaniu, rozrywce, a nawet jako osobisty asystent w codziennych zadaniach. Jego sukces nie był tylko kwestią technologii – był dowodem na to, że AI może stać się powszechnie dostępna, użyteczna i intuicyjna, nawet dla osób bez zaplecza technicznego.

Architektura GPT stała się wzorcem dla kolejnych rozwiązań – od lekkich modeli działających lokalnie, po potężne systemy multimodalne, które potrafią rozumieć nie tylko tekst, ale również obraz, dźwięk, a nawet intencje użytkownika. ChatGPT zapoczątkował nową erę interakcji człowieka z maszyną – bardziej rozmowną, bardziej inteligentną i bardziej… ludzką.

Źródła:

- Rockwell, The History of Artificial Intelligence, https://sitn.hms.harvard.edu/flash/2017/history-artificial-intelligence/

- AlphaGo, https://deepmind.google/technologies/alphago/

- Watson, ‘Jeopardy!’ champion, https://www.ibm.com/history/watson-jeopardy

- LeCun, Deep learning, https://www.cs.toronto.edu/~hinton/absps/NatureDeepReview.pdf

- Alpaydin, Machine Learning: The New Ai, publisher: The MIT Press, Cambridge, 2016

- Taulli, Artificial Intelligence Basics: A Non-Technical Introduction, publisher: Apress, Monrovia, 2019

- Turing, Computing Machinery and Intelligence, publisher: Mind, 1950

- How ChatGPT a Natural Language Processing (NLP) Platform is Revolutionizing the Way We Communicate https://medium.com/@digitalbrain.social/how-chatgpt-a-natural-language-processing-nlp-platform-is-revolutionizing-the-way-we-communicate-8b92f4bf4591

- McCulloch and W. Pitts, A Logical Calculus of The Ideas Immanent in Nervous Activity, publisher: Bulletin of Mathematical Biophysics, 1943